全新 Meta-AI 可将 2D 图像转换为 3D 模型

Meta 研究人员提出了 MCC,这是一种可以从单个图像重建 3D 模型的方法。该公司从中看到了 VR/AR 和机器人技术的应用前景。

基于 Transformer 等架构和大量训练数据的 AI 模型已经产生了令人印象深刻的语言模型,例如 OpenAI 的 GPT-3 或最近的 ChatGPT。

自然语言处理的突破带来了一个核心见解:扩展使基本模型能够抛弃以前的方法。先决条件是独立于领域的架构,例如转换器,它可以处理不同模式,以及来自非结构化和部分未标记数据的自我监控训练。

结合大规模的、独立于类别的学习,这种架构近年来越来越多地用于语言处理以外的领域,如图像合成或图像分析。

Meta MCC 为 3D 重建带来规模化处理

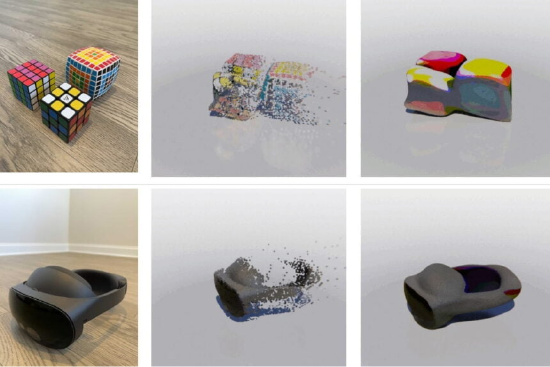

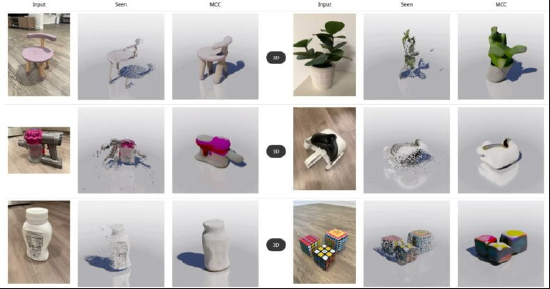

Meta FAIR Lab 展示了多视图压缩编码(MCC),这是一种基于变压器的编码器-解码器模型,可以从单个 RGB-D 图像重建 3D 对象。

研究人员认为 MCC 是迈向用于 3D 重建的通用 AI 模型的重要一步,可用于机器人或 AR/VR 应用,为更好地了解 3D 空间和对象或视觉重建开辟了许多可能性。

虽然其他方法,如 NERF 需要多幅图像,或者它们的模型需要与 3D CAD 模型或其他难以获取并因此无法扩展的数据进行训练,但 Meta 数据依赖于从 RGB D 图像中重建 3D 点。

这些具有深度信息的图像现在已经很容易获得了,这是由于带有深度传感器的 iPhone 和简单 AI 网络的普及,后者从 RGB 图像中获取深度信息。根据 Meta 的说法,这种方法具有很好的可伸缩性,而且将来很容易产生大数据集。

为了证明这种方法的优点,研究人员使用大量图像和视频来训练 MCC,这些图像和录像包含来自不同数据集的深度信息,从多个角度显示物体或整个场景。

在 AI 培训期间,模型将被剥夺每个场景或对象的一些可用视图,它们作为 AI 重建的学习信号。该方法类似于语言或图像模型的培训,其中部分数据也经常被屏蔽。

Metas 3D 重建显示了强大的通用性

Metas AI 模型在测试中显示了有效且优于其他方案的优势。该团队还表示,MCC 还可以处理以前没见过的对象类别或整个场景。

此外,MCC 显示了预期的扩展特性:随着更多的训练数据和更多样化的对象类别,性能显著提升。ImageNet 和 DALL-E 2 图像也可以在 3D 点云中重建,并提供相应的深度信息。

原文来自http://vr.sina.com.cn/news/hot/2023-02-01/doc-imyeekun8713710.shtml

元宇宙将来,我们如何应对

元宇宙将来,我们如何应对  爱立信与 Orange Poland 合作推出 VR 培训计划

爱立信与 Orange Poland 合作推出 VR 培训计划